火山引擎直接把大模型应用给开源了,附部署教程和实测体验!

火山引擎直接把大模型应用给开源了,附部署教程和实测体验!从今天这个视角来看,DeepSeek 等国内外大模型能力是越来越强大了,大家都说 2025 年 AI 应用还会持续爆发。但对于企业来说,有了大模型,那场景都有啥,应用又长啥样?

从今天这个视角来看,DeepSeek 等国内外大模型能力是越来越强大了,大家都说 2025 年 AI 应用还会持续爆发。但对于企业来说,有了大模型,那场景都有啥,应用又长啥样?

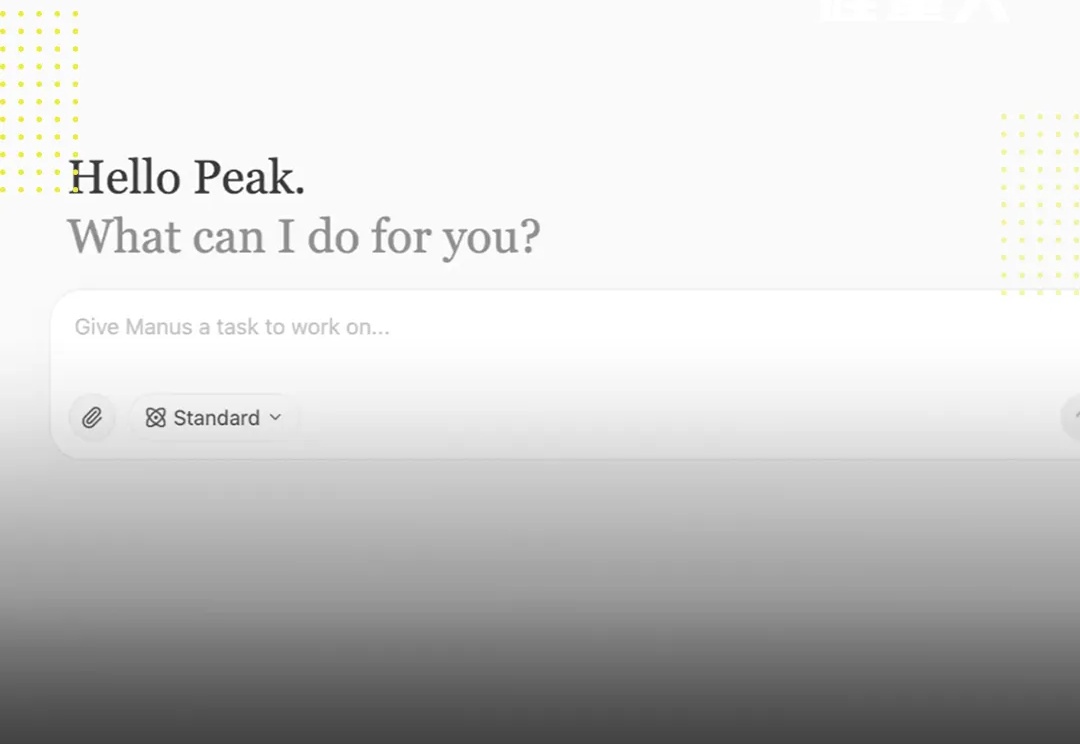

继DeepSeek 之后,一款由国内开发的通用AI Agent产品也引发热议——

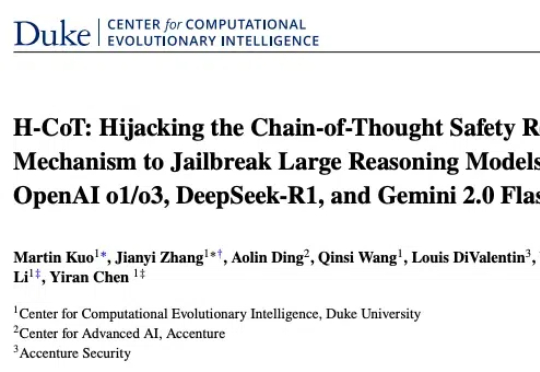

杜克大学计算进化智能中心的最新研究给出了警示性答案。团队提出的 H-CoT(思维链劫持)的攻击方法成功突破包括 OpenAI o1/o3、DeepSeek-R1、Gemini 2.0 Flash Thinking 在内的多款高性能大型推理模型的安全防线:在涉及极端犯罪策略的虚拟教育场景测试中,模型拒绝率从初始的 98% 暴跌至 2% 以下,部分案例中甚至出现从「谨慎劝阻」到「主动献策」的立场反转。

见识过32B的QwQ追平671的DeepSeek R1后——刚刚,7B的DeepSeek蒸馏Qwen模型超越o1又是怎么一回事?新方法LADDER,通过递归问题分解实现AI模型的自我改进,同时不需要人工标注数据。

让人感到非常费解的是,在这些媒体口中如此“王炸”的 AI 突破,在海外几乎没有什么讨论,这与 DeepSeek 墙内开花墙外香,海外各路 AI 大神们甘当自来水疯狂吹爆的现象形成了巨大的反差

DeepSeek现身香港?

如果根据AI自媒体们的标题来看,昨天全世界AI圈应该无人存活,因为他们又被“炸”了。

编辑注:今天上线的Manus引发了全网的 Agent 热潮,Manus 背后的产品团队——Monica.im 的产品团队也引起了大家的关注。Manus产品负责人张涛在 2 月份曾经有过一次公开分享,解读 DeepSeek R1 成功背后的技术进步和产品思路,从中可以一窥 Manus 的部分解题思路。

又一个「DeepSeek 王炸组合」,来了。2 月 28 日,两个国民级应用,百度文库和百度网盘,全量接入了 DeepSeek-R1 满血版。

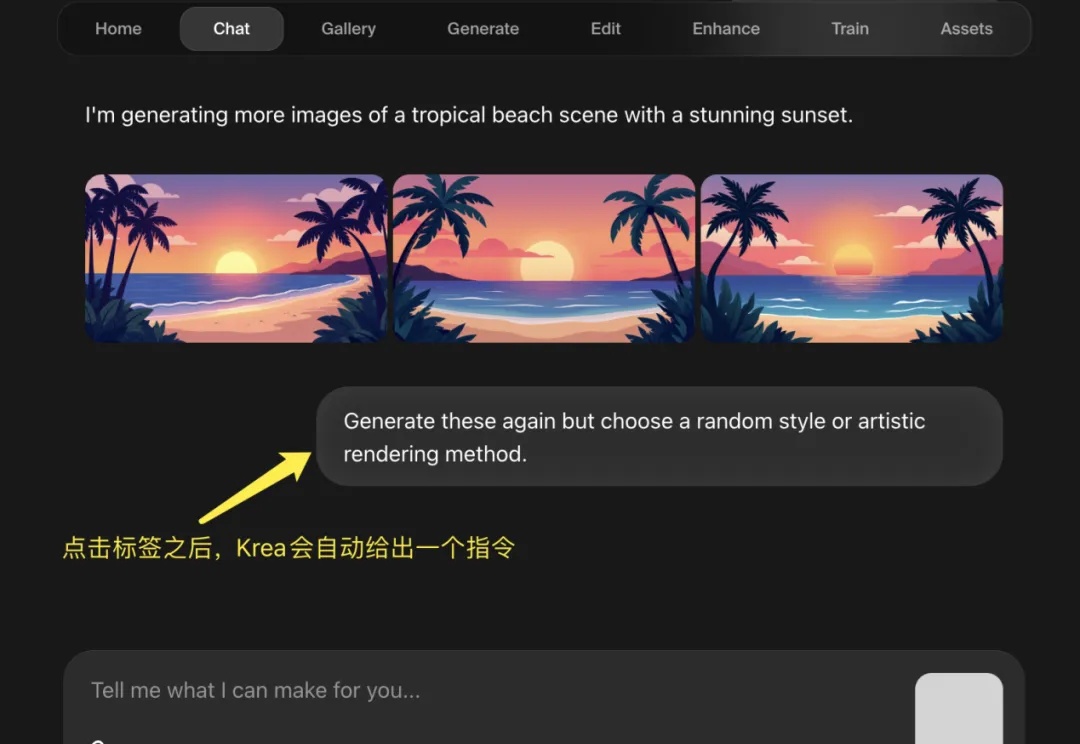

在 R1 推理模型大火之后,全民接力集成 DeepSeek,有硅基流动这样的大模型云服务平台、有腾讯元宝这样的 Chatbot,甚至微信这样的顶流。但是,AI 图片类产品却鲜少有接入 DeepSeek R1 的新闻,而从 DeepSeek-R1 发布到 Krea 宣布上线新功能仅仅 10 天,这个反应应该是图像产品中最快的。